生成AIは、うまく導入できた企業にとっては、競争優位性をもたらす強力な手段となる。私たちが行った最新の科学的実験によると、生成AIが適切な方法で、適切な業務に使用された場合の能力は、アウトプット(出力された回答)の質を向上させようとする人間の努力が裏目に出るほど精度の高いものであることが明らかになった。しかし、この新しいテクノロジーをどんな場合に使用するのが最適なのか(あるいは、どんな場合には使用すべきでないのか)は明白ではない。また、アウトプットの説得力の高さから、適用のミスマッチに気づくのは難しい。これは深刻な結果を招きかねない。つまり、 生成AI を誤った方法で、不適切な業務に使用すると、価値を著しく破壊してしまう危険性がある。

この実験は、ハーバード・ビジネス・スクール、マサチューセッツ工科大学(MIT)スローン経営大学院、ペンシルベニア大学ウォートン・スクール、ウォーリック大学の研究者たちの協力を得て実施した

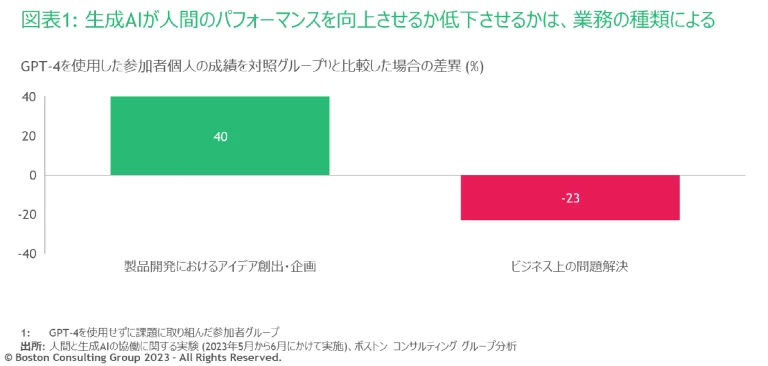

パフォーマンスを強化する観点では、驚くべき結果が見られた。生成AI(実験ではオープンAIのGPT-4を使用)を「製品開発におけるアイデア創出・企画」(コンセプトの考案とコンテンツ作成を含む業務)の課題に使用した場合、実験参加者の約90%が成績を向上させた。さらに、GPT-4を使わず同じ課題に取り組んだ参加者よりも総じて40%高い成績をあげた。また、参加者がGPT-4のアウトプットを「改良しようとせず、そのまま回答に用いた」場合に、最も高い成績が得られるという結果になった。

創造的なコンセプトの考案は、現時点で生成AIがこなせる作業の範囲内にある仕事だ。これに対し、範囲外の仕事である「ビジネス上の問題解決」(インタビュー資料と財務データに基づく示唆の抽出と、アクションプランの提示を含む業務)にGPT-4を使用した場合、使用しなかった参加者よりも成績が23%低かった。GPT-4が誤答を出す可能性について注意喚起されていた参加者でさえ、アウトプットを参考にし過ぎてしまっていた。

GPT-4がこなせる作業の範囲内の課題については、GPT-4を使用したほぼ全員が成績を向上させた。反対に、範囲外の課題にGPT-4を用いた場合、使用しなかった参加者よりも成績が低かった。

この実験結果には、あるパラドックスが表れている。人間は、生成AIが大きく価値貢献できる分野では不信感を抱き、逆に生成AIに適性がない分野では期待を寄せすぎているようだ。これは問題ではあるが、組織がこうした行動を是正したとしても、リーダーが注意すべき落とし穴は他にも潜んでいることがわかった。私たちの研究によると、生成AIのアウトプットは比較的均一なため、グループとしての思考の多様性が41%低下する可能性がある。

この研究で明らかになった生成AIがもたらす効果の大きさは、正確には状況により異なるだろう。しかし私たちの発見は、あらゆる業界のリーダーにとって重要な意思決定に示唆を与える。リーダーは自社が行っている仕事について、また、どの業務が生成AIの恩恵を受けるか、あるいは悪影響を受けるかについて、批判的に考える必要がある。AIの導入を、データ・インフラ、厳密なテストと実験、既存の人材戦略の見直しにまで及ぶチェンジマネジメントの取り組みとして捉え、取り組まなければならない。おそらく最も重要なのは、生成AIの能力の領域が拡大するのに伴い、リーダーは意思決定を継続的に見直す必要があるということだ。

問われる価値

この結果は、生成AIの導入が“もろ刃の剣”であることを明らかにしている。実験では、製品開発におけるアイデア創出・企画でGPT-4を使用した参加者の成績が、対照グループ(GPT-4を使用せずに課題に取り組んだ参加者グループ)を40%上回った。しかし、ビジネス上の問題解決では、GPT-4を使用した参加者は対照グループよりも23%低い成績にとどまった(図表1)。

製品開発におけるアイデア創出・企画の課題では、参加者は新製品と市場進出(go-to-market)計画のアイデアを出すよう求められた。ビジネス上の問題解決の課題では、業績データと幹部へのインタビューに基づいて、企業の課題の根本的な原因を特定するよう求められた(詳細は「実験の設計と手法について」をご参照ください)。少し意外に思われるかもしれないが、現在の生成AIモデルは、前者のタイプの業務で使う方が効果を発揮しやすい。大規模言語モデル(LLM)にとっては、訓練された膨大なデータに基づいて、創造的で斬新な、あるいは有益なアイデアを思いつくことはたやすいのだ。LLMがミスを犯しやすいのは、微妙な定性的データと定量的データを比較検討して複雑な問いに答えを出すよう求められる場合である。この短所を踏まえると、参加者がビジネス上の問題解決(この課題には「正解」がある)で解答を導き出す際、自分自身の判断を働かせずGPT-4のアウトプットをうのみにしてしまうと、誤答につながる可能性が高いことを研究者側は理解していた。

実験の設計と手法について

課題設計

実験では2つの課題が用意され、それぞれ別のグループの参加者が取り組んだ。

最初の課題は、「製品開発におけるアイデア創出・企画」に焦点を当てたものである。参加者は、ニーズを解決する新製品の案をブレーンストーミングで出し合い、それぞれのビジネスケースを作成し、テスト・発売計画を立て、提案の採用に向けて周囲を説得するメモを書くよう求められた。以下は、参加者に与えられた質問の一部である。

- あなたはある靴メーカーの新製品開発部門に所属しています。ニーズが満たされていない特定の市場、もしくは特定のスポーツ向けに、新しい靴を考案してください。創造力を発揮し、少なくとも10個の案を出してください。

- その製品を発売するために必要な手順の一覧を考え、簡潔かつ包括的に示してください。

- あなたの知識を最大限活用して、履物市場をユーザー別にセグメント化してください。ターゲットとするセグメントごとにマーケティングスローガンを考えてください。

- ターゲットとして特定した顧客層に対して、自分のマーケティングスローガンが効果的かどうかをテストする3つの方法を提案してください。

- 製品のプレスリリースに使うマーケティングコピーを書いてください。

- クレンディング(架空の会社)のCEOであるハロルド・ヴァン・ミルダース氏は、自社の3つのブランド(クレンディング・マン、クレンディング・ウーマン、クレンディング・キッズ)の業績を把握し、根本的な問題を突き止めたいと考えています。会社関係者のインタビューを添付します。また、添付のエクセルシートには、ブランド別の財務データが記載されています。

- この情報を使って、CEOが会社の売上成長を推進するために集中的に投資すべきブランドを1つ選ばなければならないとしたら、それはどのブランドであり、その根拠は何でしょうか。自分の提案の裏付けとしてデータやインタビューを引用してください。

製品開発におけるアイデア創出・企画の課題は、GPT-4のLLMとしての強みが発揮されるように設計された。製品開発の仕事には創造性や改善力、説得力のある文章を書くことが求められるが、いずれもGPT-4が持つ能力の範疇に含まれる。ビジネス上の問題解決の課題は、明らかにGPT-4にとって難度高く設計された。この課題は、明確な正解があるものの、GPT-4が最初の回答では不正解になるように複雑な設計で作られている。参加者は、与えられたインタビューメモとデータから自分自身の判断でニュアンスを読み取るか、またはGPT-4にうまく「考え抜く」よう促すことで、課題を解いた。

基本的習熟度の測定

参加者は実験課題に取り組む前に、AIツールを使用せずに基礎課題を解いた。この課題は、難易度や要求されるスキルの観点で、実験課題とほぼ同程度になるよう設計された。

この基礎課題の成績を、実験課題と同じ採点基準(次の項目で詳述)で評価することで、特定の業務における参加者の基本的習熟度を把握できた。これにより、業務上の習熟度が異なる個人同士を比較した際の成績に、GPT-4の使用がどう影響するのかを理解できるようになった。

採点基準

課題ごとに独自の採点基準を設けた。

「製品開発におけるアイデア創出・企画」については、創造性、説得力のある文章を書くスキル、分析的思考、総合的な文章力の4つの側面について、1~10で評価。各評価の平均を総合成績とした。

「ビジネス上の問題解決」については、解答の正確性(どのチャネルやブランドが、会社の売上や利益率を最も高める可能性があるか)で評価された。成績は2段階(正しいか正しくないか)で評価された。

実験の設計

実験に参加した758人の参加者は、主要な人口統計学的変数のコントロールに基づき、2つの課題(「製品開発におけるアイデア創出・企画」、または「ビジネス上の問題解決」)のいずれかに無作為に割り当てられた。さらに各課題の中で、3つのグループに無作為に振り分けられた。

- グループA: GPT-4を使用したベストプラクティスに関する30分のトレーニング(「実施したトレーニングについて」をご参照ください)の後、GPT-4を使って課題を解いた参加者

- グループB: トレーニングなしでGPT-4を使って課題を解いた参加者

- グループC: 課題にGPT-4を使用しなかった参加者(対照グループ)

インセンティブの導入

この実験の要は、ビジネス・プロフェッショナルたちが行う実際の業務に近づけて課題を設計していることである。参加者がビジネスの場で実際にどのように行動するかを実験によって十分に把握するため、参加者が手を抜かないよう、インセンティブが導入された。

まず、参加者の年2回の業績評価にこの実験への参加が記載された。実験での好成績は記録され、最終的には参加者の年間成績賞与に反映。加えて、上位20%の成績優秀者は上司に呼び出され、今後も高いパフォーマンスを発揮するよう激励された。

採点方法

基礎課題、実験課題ともに、参加者の解答は人間(BCGのコンサルタントと、学術研究課題を採点した経験があるビジネススクールの学生)によって採点された。採点者は、各解答がGPT-4を使用したものかどうかは知らされなかった。さらに、採点者特有の固定効果(採点の厳しさには個人差がある)をコントロールし、結果が偏らないようにした。

また、別途GPT-4を使って人間の採点者と同じ採点基準に従い、すべての課題について成績を採点した。人間による評点とGPT-4による評点はほぼ一致し、同様の結果にたどり着いた。学術的慣行に従い、ここで紹介する分析は主に人間による評点に基づいている。ただし、基礎課題と実験課題における成績分布の変化に関する分析はこの限りではなく、課題間で採点の一貫性を高く保つためにGPT-4の評点を用いた(人間による評点は、同じ参加者の解答を、基礎と実験でそれぞれ異なる採点者が採点した可能性があるため)。

実験の詳細については、注釈1に記載の 学術論文で説明している。

また、研究者側は、参加者にはビジネス上の問題解決の課題を自力で解ける能力があることもわかっていた。実際、対照グループ(課題にGPT-4を使用しなかった参加者グループ)の85%が自力で答えを導き出している。しかし、この課題にGPT-4を使用した参加者の多くは、GPT-4の誤ったアウトプットを参考にし過ぎてしまった。GPT-4の説得力ある内容を生成する能力が、この結果を招いたと考えられる。非公式に参加者に話を聞いたところ、GPT-4が提示した理論的根拠には非常に説得力があったと多くの人が認めている(LLMの性質上、理論的根拠に基づいてアウトプットを作成しているのではなく、アウトプットの後に理論的根拠を作成しているのだとしても、である)。

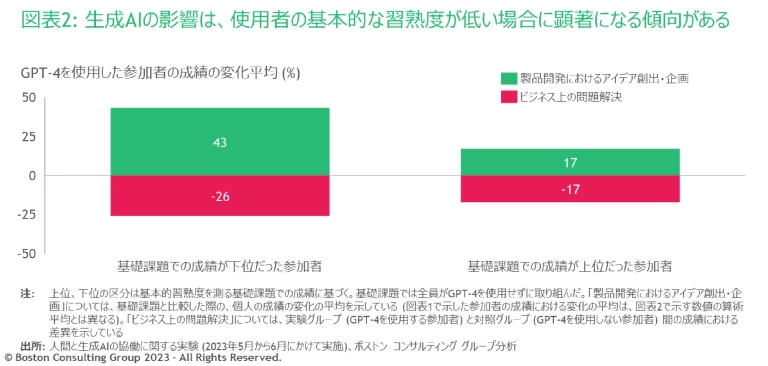

この“もろ刃の剣”的効果は、基本的習熟度の高低にかかわらず当てはまる(実験開始時に、参加者はGPT-4を使用せずに基礎課題を解き、私たちが採点して順位をつけた。詳細は「実験の設計と手法について」をご参照ください)。注目すべき点として、基本的習熟度が低ければ低いほど、その効果は顕著になる傾向があった。製品開発におけるアイデア創出・企画の課題では、基本的習熟度の低い参加者の成績が43%向上した。同様に、この効果は基本的習熟度が上位だった参加者にとっても重要な影響があり、2つの課題(「製品開発におけるアイデア創出・企画」と「ビジネス上の問題解決」)でGPT-4を使用した場合、前者では基礎課題の成績から17%向上。後者では対照グループの成績より17%低かった(図表2)。ただし実験全体を通して、参加者の成績に関する議論は、用意した課題をはじめ他の業務に関する参加者の能力や才能の絶対的水準を示すものではない。

参加者の成績と、生成AIが使用される文脈との間に強い関連が見られることから、次の重要な疑問が生じる。生成AIがその業務にどれだけ適しているのかを理解できれば、パフォーマンスが低下するリスクを減らせるのだろうか。もし参加者がGPT-4の限界を知っていれば、「不適切な状況ではGPT-4を使わない」、もしくは「使い方を変える」だろうと考えるのは理にかなっている。

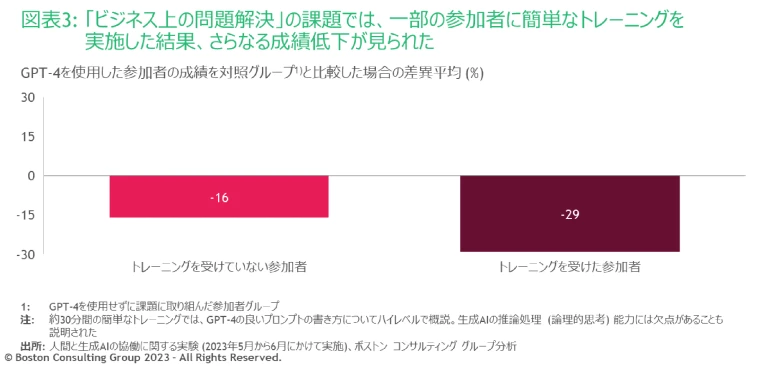

しかし、今回の結果はそう単純ではない。参加者にGPT-4のプロンプト(生成AIに入力する質問・指示)の書き方とこのテクノロジーの限界について説明した場合でも、ビジネス上の問題解決の課題でGPT-4が及ぼす悪影響は解消されなかった(「実施したトレーニングについて」をご参照ください)。

実施したトレーニングについて

ビジネス上の問題解決の課題では、この文脈でGPT-4を使用する際の難点と落とし穴について説明された。GPT-4が推論処理(論理的思考)において陥りがちな失敗例を見せられ、そのような業務ではGPT-4にあまり頼りすぎないよう注意を受けた。

さらに不可解なことに、事前にこの簡単なトレーニングを受けた参加者は、受けずにGPT-4を使用した参加者よりも、平均して大幅に成績が低かったのである(図表3)。これはトレーニング自体が無意味だということではなく、トレーニングを受けたことが自信につながり、判断に影響してしまった可能性を示唆している。

人間の才能が発揮される新たな機会

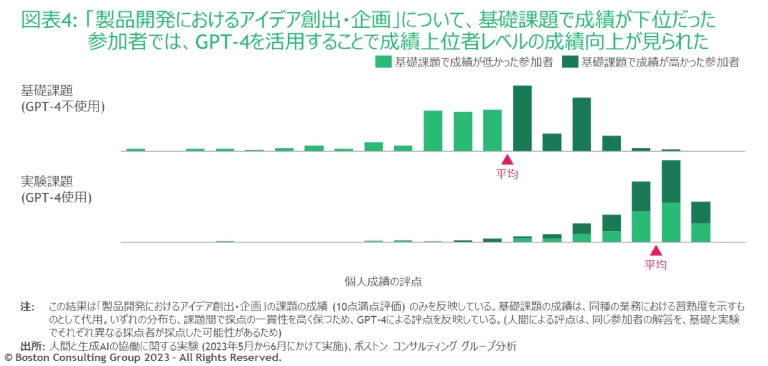

これまでに述べてきた集団レベルで見られる影響は、必ずしも生成AIが個人に与える影響を示しているわけではない。平均値ではなく個々の成績を見てみると、GPT-4の使用は個人の成績分布に異なる2つの影響を与えることがわかる(図表4)。第一に、分布全体が右(より高い成績)へシフトしている。これは、前述した約40%もの成績向上が、「ポジティブな外れ値」(標準よりも大幅に高い成績を出した人)のせいではないことをはっきりと示唆している。製品開発におけるアイデア創出・企画の課題にGPT-4を使用した場合、基本的習熟度に関係なく、ほぼすべての参加者(約90%)がより質の高い解答を出した。第二に、成績のばらつきが劇的に減少した。平均的な成績を収めた参加者の割合が、GPT-4を使用した場合の方が高かった。

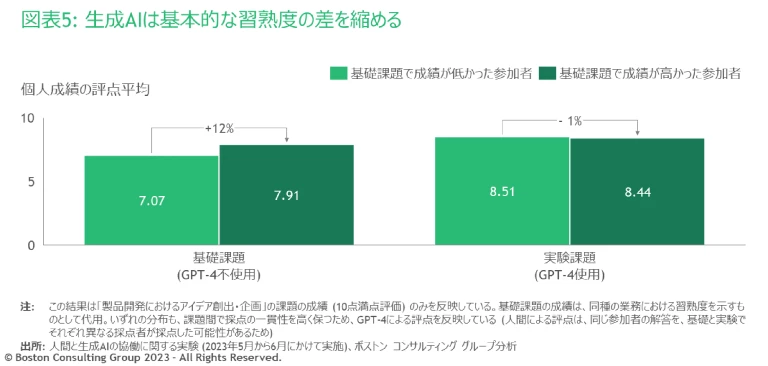

言い換えれば、基本的習熟度の低い参加者が生成AIを使用した場合、習熟度の高い参加者とほぼ同じ結果になったということである。製品開発におけるアイデア創出・企画の業務で誰もがGPT-4を使えば、テクノロジーの助けなしに能力の高い人であっても、それほど優位には立てない(図表5)。高学歴で成績優秀な実験参加者の間でこの影響が観察されたということは、より習熟度に幅があって不均質な状況では、この影響がさらに顕著になる可能性がある。

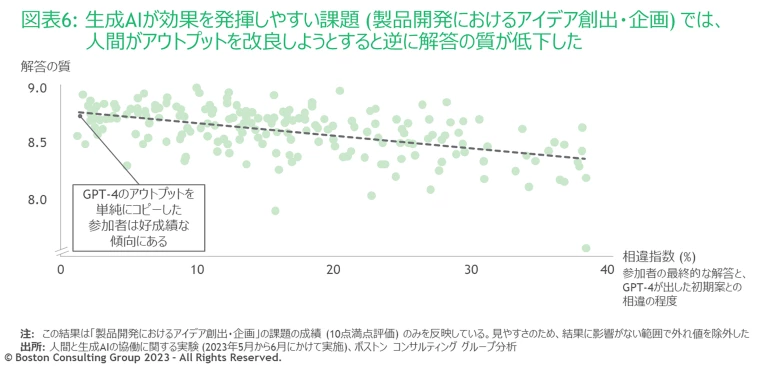

さらに掘り下げると、GPT-4は製品開発におけるアイデア創出・企画の業務において非常に高いレベルに達しているため、平均的な人間がGPT-4のアウトプットを改善する余地はないようだ。実際に、GPT-4の出力を改良しようとすると、最終的に人間が出す解答の質は低下する(質の評価については「実験の設計と手法について」をご参照ください)。私たちは、GPT-4のアウトプットを「コピー&ペースト」することが、成績と強く相関していると気づいた。製品開発におけるアイデア創出・企画の課題において、参加者の最終的な解答がGPT-4の初期案から離れれば離れるほど、解答の質が低下する可能性が高くなる(図表6)。GPT-4の初期案からの相違指数が10%高くなるごとに、解答の評点順位は平均で約17%低下した。

人間主導で価値を創造すべきところは、生成AIがすでに優秀な分野でそれをさらに強化することではなく、このテクノロジーのコアコンピタンスの範囲外の業務に注力することにあるようだ。

興味深いことに、参加者のほとんどがこの点を直感的に理解しているようだった。参加者は総じて、生成AIに脅威を感じていなかった。むしろ自分の役割が変わることにおもしろさを感じ、人間にしかできない仕事を引き受けるという考え方を受け入れていた。ある参加者は次のように話した。「人間だからこそできることには、多くの付加価値があると思います。生成AIが出した答えをビジネスの文脈に適用するには人間が必要で、そのプロセスをAIで代替することはできません」。別の参加者は「効率的に物事を進め、明らかに反復的な仕事に時間を費やすのをやめて、重要なこと、つまり“もっと戦略的なこと”に集中するチャンスだと思います」と指摘した。

ただし、この調査の対象者は高度なスキルを持つ若いナレッジワーカー(知識労働者)であり、役割の変化に比較的対応しやすいことを念頭に置く必要がある。他の働き手の場合は、自分の役割をテクノロジーに適応させるのにより大きな恐怖感をもったり、難しさを感じたりするかもしれない。

創造性の罠

生成AIを適切な方法で適切な業務に使用したとしても、創造性の面でリスクがあることが、今回の研究で示唆されている。

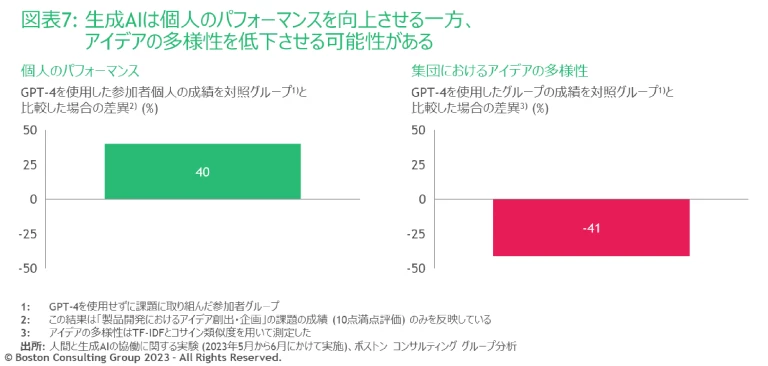

1つ目のリスクは、「個人のパフォーマンス向上」と「集団の創造性低下」のトレードオフである。GPT-4は、同じ種類のプロンプトに対して何度も似たような回答を出力する。そのため、GPT-4を使用した参加者が提出した解答は、個々人で見れば優れていたが、集団で見ると同じような内容になっていた。製品開発におけるアイデア創出・企画の課題でGPT-4を使用した参加者のアイデアの多様性は、使用しなかったグループと比較すると41%低かった(図表7)。GPT-4のアウトプットを編集した場合でも、個性はさほど出せなかった。

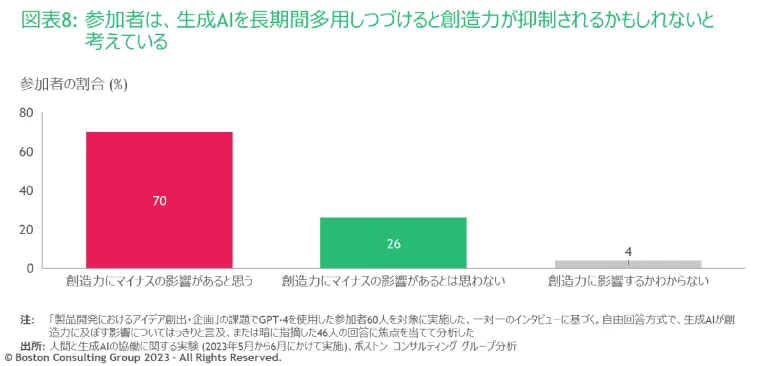

2つ目のリスクは、参加者へのインタビューから引き出された。約70%の参加者が、GPT-4を長期間多用しつづけると自身の創造力が抑制されるかもしれないと考えている(図表8)。ある参加者はこう語る。「どのようなテクノロジーにも言えますが、人間はそれに頼りすぎてしまう場合があります。GPSが発売された当初は乗り物のナビゲーションにとても役立ちましたが、今となってはGPSなしでは運転すらできない。テクノロジーに依存しすぎると、人間はかつて持っていた能力を失ってしまうのです」。別の参加者は「私はどうしてもこの現象を懸念してしまいます。GPTに依存しすぎると創造性の“筋力”が弱まってしまうでしょう。すでに今回の実験の間にもそのようなことが起きました」と話す。企業は、 生成AIに対する従業員の認識や態度 に気を配る必要がある。そして、そうした認識や態度が、イノベーションを推進し付加価値を高める組織の力にどのように影響を与える可能性があるのか、留意する必要があるだろう。

参加者の認識を確かめるデータはまだなく、今後の研究の課題としたい。しかし、従業員の懸念が裏付けられれば、集団にとってのリスクはさらに高まる可能性がある。具体的に言うと、個々の従業員の創造性が衰えた場合、集団としてのアイデアの多様性がさらに失われる可能性がある。

生成AIによる変革を実現する必須要件

私たちはこの研究結果に着想を得て、ビジネスリーダーが生成AIの導入を差別化の源泉とし、それによって持続的な競争優位性を実現するのに役立てられる問いや課題、選択肢を導き出した。

データ戦略 企業は生成AIを導入すれば、生成AIが得意とする領域で大幅な効率化を実現できる。しかし、複数の企業が同じような業務にこのテクノロジーを適用した場合、実験の参加者間で見られたパターンと同様に、企業間でも「平準化」効果が生まれてしまうおそれがある。その結果、高品質で自社固有のデータを大量に使用して生成AIモデルを微調整(ファインチューニング)する力が、差別化のカギの一つとなるだろう。

これは、言うは易く行うは難しである。私たちのコンサルティング経験から考えるに、自社固有のデータを処理するのに必要な高度なデータ・インフラの組織能力は、すべての企業が持っているわけではない。こうした組織能力の開発はこれまでもAIトランスフォーメーションの主要な焦点だったが、生成AIの登場により、その重要性はさらに高まっている。 本論考以外でも論じてきたが 、生成AIの威力は、予期しなかった、もしくは直感に反するパターンや相関関係を見つけ出すところにある。企業がその利点を享受するには、社内のデータエンジニアリング能力の開発に改めて注力することとあわせて、包括的なデータのパイプラインが必要となる。

職種とワークフロー 生成AIが習得した業務(当然ながら、この範囲は今後拡大していく)については、人間は仕事に対する考え方やアプローチを根本的に見直す必要がある。「テクノロジーを使って役に立つ初期案を作成し、それを修正する」というやり方を前提とするのではなく、生成AIのアウトプットを妥当性の高い最終案とみなすべきだ。しっかりと確立されたガードレール(安全確保のための対策)に照らし合わせてアウトプットを確認することは必要だが、それ以外の部分はそのまま使うのである。

生成AIの価値は効率性の大幅な向上だけでなく、一部業務を肩代わりすることによって、人間がそこに費やしてきた時間や労力を他に向けられるという点にもある。従業員は生成AIの能力の範疇にはない仕事に注力することで、より高いレベルに到達できるだろう。

生成AIの価値は効率性の大幅な向上だけでなく、一部業務を肩代わりすることによって、人間がそこに費やしてきた時間や労力を他に向けられるという点にもある。

私たちコンサルタントの仕事についてはどうかというと、従業員が手作業で調査をまとめたりスライド資料を磨き上げたりする時間を減らし、代わりに複雑なチェンジマネジメントの取り組みにより多くのリソースを費やすことはすでに想定できる。もちろん、生成AIが及ぼすディスラプション(創造的破壊)の影響は職種によって大きく異なるだろう。しかし、少なくとも一部の働き手(大多数の実験参加者を含め)は、この見通しに楽観的に向き合っている。

戦略的な人材計画 複雑な組織の中で、AIと人間がいかに協働できるかを正確に理解するためには、リーダーは次の4つの難問に取り組まなければならない。

- どのような組織能力が必要か 他のテクノロジーと同様、生成AIを何に、どのように使うかを判断するには人間が必要だ。しかし、生成AIの価値を最大化するには、どのような人間の組織能力が最適なのか、また、それらの組織能力がどのくらいのスパンで変化するのかは不透明だ。LLMに関してはまさに今、この不確実な事態が起きている。「プロンプトエンジニア(AIに指示を出す専門家)」という職種は1年前には存在しなかったが、2023年第2四半期には、この職種の需要が第1四半期の7倍近くに高まっている

2 2 2023年8月24日までのLightcast(旧BurningGlass)のプラットフォームにおけるグローバル求人情報に基づきBCGが分析 (GPT-4は第1四半期末頃、2023年3月14日に公開された)。とはいえ、生成AI自体が複雑な問題を最適なプロンプトに分解する作業を習得すれば、プロンプトエンジニアはもはや不要となるかもしれない(自律型エージェント3 3 世の中のデータをつなぎ、自ら学習を繰り返すAI により、間もなく現実となりそうだ)。現在は特定のビジネスアプリケーション4 4 ワープロや表計算,データベースなど日常的な事務処理で利用されるソフトの総称 に最適なLLMの選択などもまだ人間が行っているが、将来的にはAIシステムそのものにアウトソーシングすることになるかもしれない。 - 採用戦略はどうなるか 生成AIは、特定の業務については人材の習熟度を平準化することに優れているため、それが広く使われるようになれば、どういった人材が高いパフォーマンスを発揮するのか予測を立てるのが難しくなりそうだ。例えば、ある業務に対する基本的習熟度は低い一方、生成AIを使うととびぬけて高い能力を発揮する人材もいるかもしれない。このような個人を見つけることは、将来の人材戦略で重要な目標になるだろう。しかし、その手の人材が備えている基本的な特性はまだよくわかっていない。

どのようにトレーニングするのが効果的か 研究結果が示すように、簡単なトレーニングでは十分な効果が望めないようだ。生成AIの能力が適切なレベルに達していない分野でも人間は生成AIを頼りすぎてしまうという点を踏まえ、認知バイアス(先入観、思い込み)に対処するトレーニングが求められるだろう。

また、さらに深刻な問題も潜んでいる。ある特定の業務が完全に生成AIに代替されたとしても、人間の監督が一定程度、必要になるだろう。自分自身でやり方を学んでいない業務について、従業員はどうすれば効果的に生成AIを監督できるのだろうか。

- 思考の多様性をどのように育むか 研究結果から、生成AIは個々人が提示する視点を狭めるため、集団の創造性が損なわれることが示唆された。このような思考の多様性の喪失には、私たちが現在想定している以上に大きな波及効果があるかもしれない。例えば、創出されるアイデアの均質化などにより、組織の長期的なイノベーション能力が低下する可能性がある。イノベーション能力が低下すれば競合他社との差別化が難しくなり、成長の可能性が加速度的に阻害されていく。一方で、良い面もある。人間が自力で生み出すアイデアと、生成AIの助けを借りて生み出すアイデアは大きく異なるということだ。各グループの多様性の程度はさておき、対照グループと実験グループの解答を比較したところ、重複(類似性)は10%未満だった。リーダーにとってカギとなるのは、生成AIを使う場合と使わない場合の両方のアプローチを用いてアイデア創出を行うこと、つまり結局のところ、アイデアの輪をさらに広げることである。

実験とテスト 生成AIシステムは驚異的なスピードで発展を続けている。オープンAIのGPT-3.5が公開されてから、次のGPT-4が世に出るまでのわずか数カ月間に、このモデルは幅広い作業について性能を大きく飛躍させた。現在は生成AIが不向きとされている作業でも、おそらくごく近い将来には問題なくこなすようになるだろう。これは、LLMがマルチモーダルモデル(言語のほか、数値や画像、音声など複数のデータを組み合わせて訓練されたモデル)になるにつれて、あるいはモデルがより大規模になるにつれて実現する可能性が高い。

見通しがこれほど不確かであることを考えると、生成AIがビジネスに与える影響を理解する唯一の方法は、実験能力を培うことだ。例えば「生成AIラボ」のような組織を設立し、拡大しつづけるテクノロジーの最先端に後れをとらないようにするのである。また、生成AIの変化にあわせて、人間と生成AIのコラボレーションモデル(協働の仕方)も変わる必要がある。実験によっては、自社のビジネスにとって直感に反するような発見や、心穏やかでない発見もあるかもしれない。しかし、このテクノロジーをどう活用できるか、活用すべきなのかについて、洞察を深めることができるはずだ。私たちは今回、自らの職業で実験を行った。同様の取り組みが、ビジネスリーダーたちに広がることを願っている。

生成AIは誰も予想できない形で、私たちの物事への取り組み方を大きく変えるだろう。AI時代における成功は、組織がこれまで以上の速さで学習し、変化できるかどうかに懸かっている。

冒頭で紹介した研究チームに加え、Clément Dumas、Gaurav Jha、Leonid Zhukov、Max Männig、Maxime Courtauxの有益なコメントと提案に御礼申し上げる。また、実験参加者へのインタビューに尽力してくれたLebo Nthoiwa、Patrick Healy、Saud Almutairi、Steven Randazzoにも感謝を述べる。この実験に有志で参加してくれたBCGの同僚たちにも感謝する。

(原典: How People Can Create—and Destroy—Value with Generative AI )